방송통신대학교 인공지능 강의 정리 자료입니다.

1. 생각하는 컴퓨터

튜링 테스트(Turing Test)

: Alan Turing이 컴퓨터가 생각을 할 수 있는가를 입증하기 위한 방법으로 제안한 테스트

인간과 컴퓨터의 체스 대결

: 1차 대결(1996년)은 3승 2무 1패로 카스파로프 승, 2차 대결(1997년)은 2승 3무 1패로 Deep Blue(IBM의 RS/6000 SP 병렬 슈퍼컴퓨터에 체스 전용 보조프로세서를 장착하여 초당 2억 개의 행마를 검토할 수 있음.) 승

인간과 컴퓨터의 퀴즈 대결

: 'Jeopardy!'라는 퀴즈 쇼에서 2명의 퀴즈 달인과 IBM의 Watson 컴퓨터가 대결(2011년)하였는데 Watson(IBM에서 제작한 인공지능으로 100가지가 넘는 서로 다른 기술을 이용하여 자연어를 처리하고 가설을 설정하여 증거에 점수를 매긴 다음, 가설들을 병합하고 순위를 정해 답변하는 DeepQA 기술이 적용되었고, 총 2,880개의 POWER7 프로세스 스레드가 동작하는 대단위 병렬 시스템을 이용하여 고속으로 처리할 수 있게 만들어졌음.)이 압도적인 승리를 거둠.

인간과 컴퓨터의 바둑 대결

: DeepMind의 AlphaGo(Monte-Carlo 트리탐색, Deep learning을 이용한 머신러닝 기술이 적용되었고, 다수의 CPU와 GPU를 이용한 병렬 컴퓨터를 사용하였음.)와 프로기사 이세돌이 2016년 대국을 진행하였고, 이세돌 9단이 1승 4패로 AlphaGo에게 패함.

생성형 인공지능(Generative AI)

: 대규모 데이터 집합을 대상으로 학습함으로써 이를 일반화하여 데이터에 내재한 패턴이나 구조를 습득하는 AI로 이를 바탕으로 새로운 데이터를 생성할 수 있음. ChatGPT, Copilot, Gemini 등와 같은 chatbot과 DALL-E, Midjourney, Stable Diffusion 등과 같은 Text-to-image 모델, Sora, Runway 등과 같은 Text-to-video 모델이 있음.

생성형 인공지능의 문제점

- 윤리적 문제

: 훈련 데이터에 따른 편향된 콘텐츠 생성, 실제와 구분하기 어려운 거짓 정보의 생성, 딥페이크

- 환각

: 사실과 다르거나 비논리적인 정보의 생성이 가능함.

- 책임 소재의 불분명

: 생성된 정보가 부정확하거나 해로운 내용을 담고 있는 경우 책임을 누가 져야하는가가 애매함.

- 설명 가능성:

정보를 생성하거나 결정을 내리는 과정이나 근거의 투명성이나 신뢰성이 부족함.

지능적 시스템에 요구되는 능력

: 지식을 바탕으로 동작할 수 있는 능력, 데이터를 분석하여 예측할 수 있는 능력, 학습할 수 있는 능력, 사물을 인지할 수 있는 능력, 자연어를 이해하고 구사할 수 있는 능력, 창조할 수 있는 능력, 감성지능

인공지능의 분류

- 약한 인공지능(weak AI)

: 좁은 인공지능(narrow AI)라고도 하며 특정 작업이나 한정된 범위의 작업을 수행하도록 설계된 인공지능 시스템

- 인공 일반지능(Artificial General Intelligence: AGI)

: 강한 인공지능(strong AI)라고도 하며 사람이 할 수 있는 어떠한 지적인 작업이든 사람만큼, 혹은 사람보다 더 잘해낼 수 있는 능력을 갖춘 인공지능을 지칭함.

2. 인공지능의 탄생과 발전

인공지능의 태동

- 다트머스 회의(Dartmouth workshop)

: 1956년 Dartmouth 대학교의 마빈 민스크, 존 메카시, 너새니얼 로체스터, 클로드 섀넌 등의 제안으로 개최된 학술 회의로 'Artificail Intelligence'라는 용어가 사용되기 시작함. 자동적 컴퓨터, 컴퓨터가 언어를 사용하도록 프로그램하는 방법, 가상 신경세포의 개념형성, 계산의 규모에 대한 이론, 자기 개선, 추상화, 무작위성과 창의성 등의 인공지능 관련 주제에 대해 브레인 스토밍이 이루어졌었음. 기호처리 기법, 제한된 영역에 집중한 시스템(초기 전문가 시스템), 연역 시스템과 귀납 시스템등에 관심을 가졌으며, 초기 인공지능의 주류를 형성한 주제였음.

- 초기 인공지능 연구

: 기호처리 기법, 제한된 영역에 집중한 시스템(초기 전문가 시스템), 연역 시스템과 귀납 시스템등이 주를 이루었으며, 프랭크 로젠블랫의 퍼셉트론 모델, ADALINE, Hopfield 네트워크 등과 같은 인공 신경망의 초기 모델이 연구되었음.

직관적으로 단순하게 해결할 수 없는 문제에 대해 문제를 파악하고 문제의 해에 이르는 방법을 찾아내는 일련의 과정인 문제풀이(problem solving)에 집중하였으며 일반문제풀이기(GPS, General Problem Solver)를 만들기 위해 노력하였음.

일반문제 풀이기는 1959년 Herbert A. Simon등이 어느 문제에든 적용할 수 있는 문제풀이 기계를 만들기 위해 개발한 프로그램으로 간단한 문제의 경우 풀이가 가능했지만 실 시계의 문제에는 중간 상태의 조합 가지의 폭발적 증가로 인해 적용할 수 없었다는 문제가 있었음.

- 지식 중심형 연구로 전환

: 광범위한 지식과 문제 풀이 방법이 필요한 일반문제를 풀이하려는 시도에서 특정한 분야의 지식을 이용한 인공지능의 시스템을 구현하는 쪽으로 방향이 바뀌게 됨. 이에 따라 해결하려는 문제 분야의 전문가가 가지고 있는 지식을 논리적 규칙으로 표현하고 이를 바탕으로 특정 지식영역의 문제를 해결하려는 인공지능 시스템인 전문가 시스템(expert system)이 등장하게되었고, 질량 분석 데이터와 화학 지식을 사용하여 유기화학자가 미지의 유기 분자를 식별하는 것을 보조하는 Dendral(1965년)과 감염을 유발하는 세균을 식별하고, 이에 맞는 항생제와 투여량 등의 처방에 참고할 수 있는 조언을 제공하는 MYCIN(1972년대)가 대표적임.

이는 범용 문제풀이기가 아닌 특정 분야의 지식을 획득하고 조직화하여 문제풀이에 활용하는 방향으로 전환하는 계기가 되었음. 전문가 시스템의 주요 구성요소로는 지식을 구조화하여 컴퓨터 내부에 저장하는 지식 베이스와 지식 베이스의 지식과 외부에서 일어난 사실을 표현하고 있는 정보의 조합방법을 탐색하는 추론 기관이 있음. 이에 따라 지식을 어떻게 체계화하고 지식 베이스에 축적하며, 축적된 지식을 어떻게 이용하는가를 연구하는 지식 공학이 대두되었고, 지식의 표현 및 추론에 적합한 프로그래밍 언어(5GL), 인공지능용 컴퓨터의 개발(FGCS)등의 연구가 이루어졌음.

인공지능 연구의 침체와 부흥

- 인공지능의 겨울(AI winter)

: 인공지능 연구의 성과에 의문을 갖게 되면서 상당 기간 침체기를 겪게됨.(1970년대 중, 후반, 1990년대) 퍼셉트론과 같은 신경망 모델은 XOR와 같은 단순한 문제도 해결할 수 없음을 비판하였으며, 일반적이 지능적 행동의 대상에 해당되는 문제 영역의 규모나 난이도가 예상했던 것에 비해 매우 크고 높다는 것을 인식하게 되었었음. 즉, 컴퓨터 성능의 한계나 결과물의 성능, 유용성, 유연성, 경제성이 충분히 뒷받침되지 못했기 때문에 이와 같은 상황이 발생하게 되었었음.

- 인공지능에 대한 새로운 관심

: 실용적 수준의 응용이 가능한 다양한 딥러닝 모델들이 등장하고, 거대 언어 모델(LLM: Large Language Model)을 기반으로 한 자연어 처리의 획기적인 발전이 이루어짐과 동시에, 웹, 스마트폰, SNS 등에서 풍부한 데이터들의 생성과 GPGPU 등의 기술을 활용한 계산능력의 비약적 증대덕분에 다시 한번 관심을 받게됨.

3. 지능이란 무엇인가?

사전적 정의

: the ability to learn or understand or to deal with new or trying situations(Webster 사전)

새로운 대상이나 상황에 부딪혀 그 의미를 이해하고 합리적인 적응 방법을 알아내는 지적 활동의 능력(표준국어대사전)

→ 문제해결 능력, 학습 능력, 지식 활용 능력, 인지 능력, 다양한 상황에 대한 적응 능력등이 지능에 해당함.

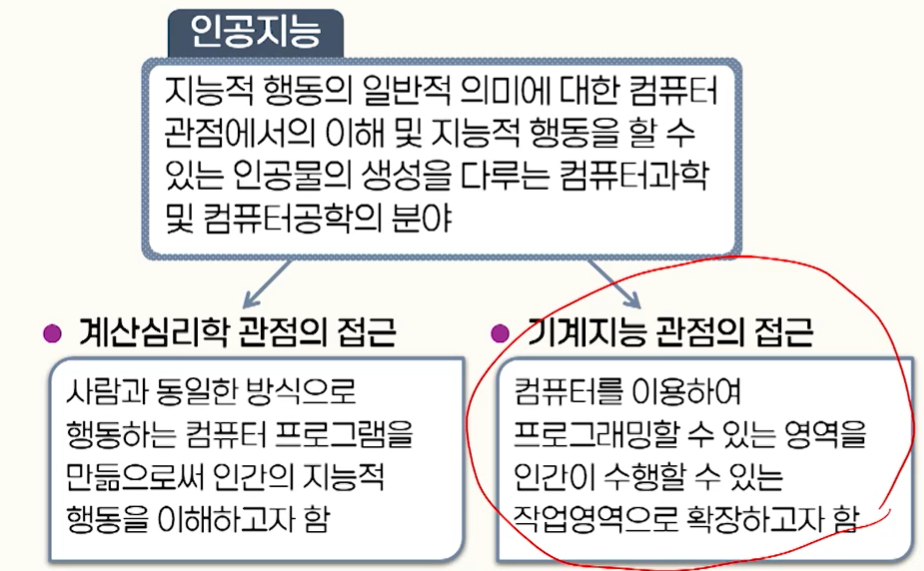

인공지능의 접근 방향

기호처리 인공지능(Symbolic AI)

- 물리적 기호 시스템 가설

: 물리적 가호 시스템을 통해 인간이 행하는 지능적 작업을 수행하는 프로그램을 작성할 수 있다는 믿음의 근원으로 초기 인공지능의 많은 연구가 이 가설에 근거하여 수행됨.(일반 문제 풀이기, 전문가 시스템 등)

- 확률 및 통계 이론의 활용

: 추론의 근거가 되는 사실이나 규칙에 불확실성이 내재하는 문제나 주어진 데이터 집합을 바탕으로 미래의 현상을 예측하거나 객체를 분류하는 문제를 해결하기 위해 접근하는 것으로 자연언어 처리, 머신러닝, 패턴인식 등의 분야에 활용함.(회귀 분석, 베이즈 분류기, 결정 트리, 서포트 벡터 머신 등)

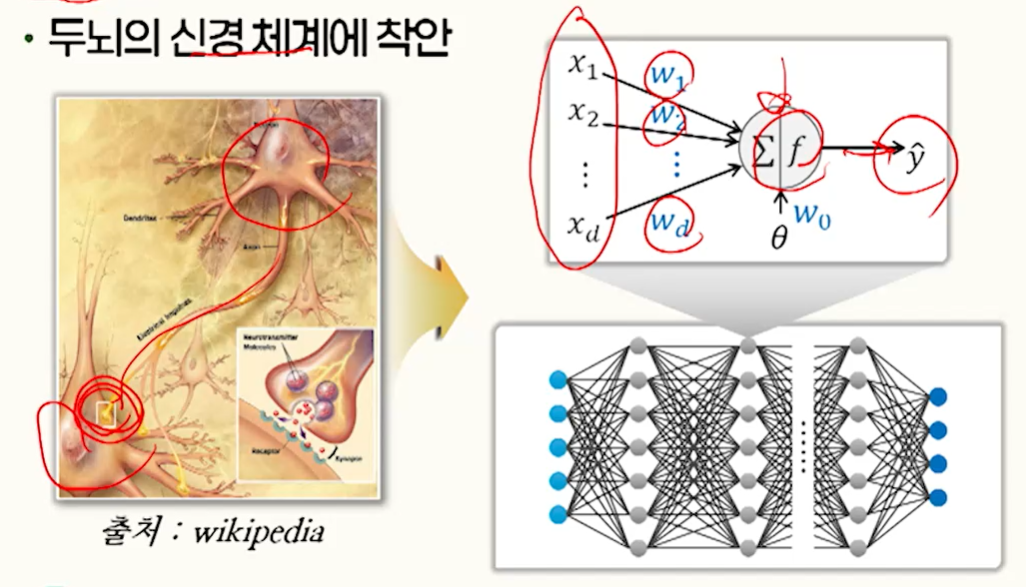

- 연결주의(connectionism)

: 두뇌의 신경 체계에 착안하여 접근하는 것으로 인공 신경망(artificial neural network), 딥러닝(deep learning)이 대표적인 예시임.

인공지능과 학습

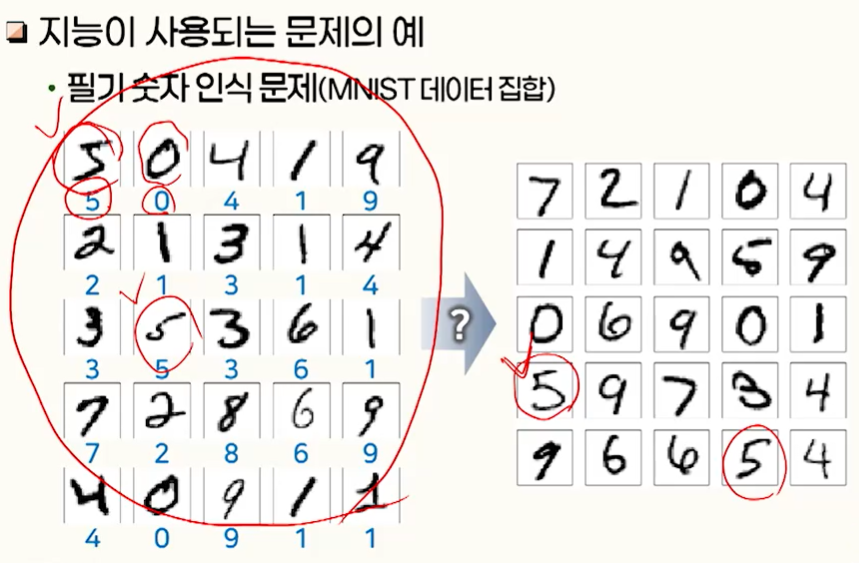

- 머신러닝(machine learning)

: 수집된 정보로부터 문제풀이에 필요한 지식을 습득함으로써 시스템 스스로 행동을 향상시키는 과정

'방송통신대학교 > 3학년 1학기' 카테고리의 다른 글

| [파이썬프로그래밍기초] 1강. 컴퓨터의 이해 (0) | 2025.04.04 |

|---|---|

| [알고리즘] 2강. 알고리즘 소개 (2) (0) | 2025.04.01 |

| [알고리즘] 1강. 알고리즘 소개 (1) (0) | 2025.03.31 |

| [데이터베이스 시스템] 5강. SQL (2) (0) | 2025.03.25 |

| [운영체제] 5강. 병행 프로세스 II (0) | 2025.03.20 |

댓글